Actions

Objectif¶

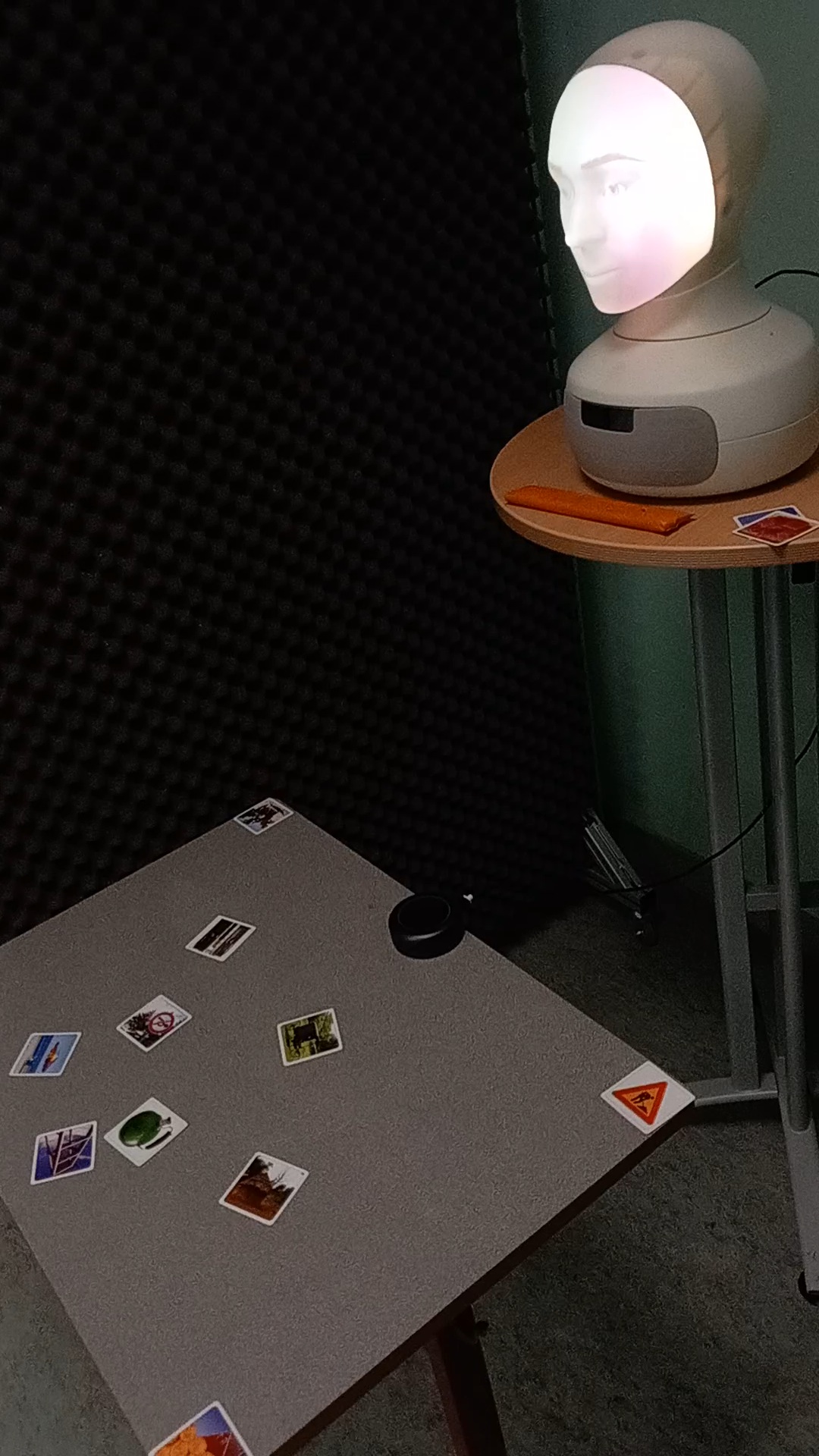

Pouvoir réaliser rapidement une maquette, en python, d'une interaction avec le robot Furhat, en faisant intervenir :- synthèse et reconnaissance de parole via Furhat (et le cloud)

- détection des interlocuteurs avec la caméra de Furhat

- détection visuelle avec une caméra externe et YOLO (cartes et main vues de dessus par exemple)

- gestion du regard/orientation de la tête du robot vers les interlocuteurs ou les cartes détectées par YOLO

{ <<< Cliquez sur l'image pour voir la vidéo résultat de l'après-midi Kaleidoscope avec 4 étudiants}

{ <<< Cliquez sur l'image pour voir la vidéo résultat de l'après-midi Kaleidoscope avec 4 étudiants}

Crédits vidéo : Frédéric ELISEI (GIPSA-lab), avec Benjamin POIREAULT (Ense3), Alexis LE MEUR (Ensimag), Kinjy BIALADE (Ense3) et Ivan PETERSCHMITT (Ensimag)

Voir les détails de API :

https://redmine.gipsa-lab.grenoble-inp.fr/projects/furhat_interaction/wiki/API?parent=Lib_yarp_APP

Mis à jour par Frederic Elisei il y a 10 mois · 43 révisions